Under Pressure – Über Formen des Autoritären und die Macht der Entscheidung

Eröffnung

Do 27.09., 19hZeitraum

28.09. bis 25.11.2018Öffnungszeiten

Di-So 13-16h, 16.30-20hEintritt

freiPresseführung: Di 25.09., 10h

Führung mit Kuratorin Sabine Winkler und Elisabeth Hajek, künstlerische Leitung: Do 22.11., 17h im Rahmen der VIENNA ART WEEK

Künstler_innen:

Rod Dickinson (GBR)*, İnci Eviner (TUR), HARD-CORE (NLD, FRA, ISL)*, Minna Henriksson (FIN)*, Bernd Hopfengärtner* & Ludwig Zeller (GER), Vladan Joler (SHARE Lab)(SRB), Isabella Kohlhuber (AUT), Stéphanie Lagarde (FRA), Liz Magic Laser (USA), Daniela Ortiz (PER/ESP), Olivia Plender (GBR), Sebastian Schmieg (GER), Stefanie Schroeder (GER)*, Superflux (IND/GBR, GBR), Nick Thurston & Steven Zultanski (GBR, USA), Pinar Yoldas (TUR/USA)

*Q21 Artists-in-Residence

Ausgangspunkt für die Ausstellung sind jene in jüngster Zeit vermehrt auftretende autoritäre Tendenzen, die zunehmend in politischen und ökonomischen Bereichen sowie in Umgebungen der KI-Entwicklung auftauchen. Das Zustandekommen von Mehrheiten für autoritär agierende PolitikerInnen, ein offensichtlich autoritär agierender Finanzmarkt, sowie autoritäre Strukturen informationstechnischer Systeme und autoritäre Tendenzen in der KI-Entwicklung führen zu der Frage, ob neue Formen des Autoritären sich dadurch unterscheiden, dass sie individuelle Freiheiten erlauben oder zumindest diesen Eindruck vermitteln.

In der Ausstellung geht es um die Frage, welche Mechanismen, Strategien und Taktiken bei der Einschränkung von Entscheidungsfreiheiten zum Einsatz kommen, wie über Sicherheit/Schutz, Ökonomie/Finanz, Nation/kulturelle Identität oder die erklärte Notwendigkeit von Konkurrenz und Effizienz Kategorien für Entscheidungsprämissen definiert und festgelegt werden. Ausgehend von Dogmen des Neoliberalismus und des Neonationalismus beschäftigt sich die Ausstellung mit Autoritarismen in Politik, Ökonomie, Technologie und Kunst. So führte die vom Neoliberalismus betriebene Marginalisierung des Politischen sowie die Finanzkrise zu einem beschleunigten autoritären Kapitalismus. Der autoritäre Neonationalismus wiederum kann u. a. als eine Reaktion auf diese Entwicklung gesehen werden.

Kontrolle über zukünftige Entscheidungen und Handlungsweisen sowie Einflussnahme sind hingegen das Ziel von präemptiv agierenden, algorithmischen Systemen und Regierungsformen. So werden durch informationstechnische Antizipation und technische KI-Assistenten, wie Siri, Cortana oder Alexa Handlungsprogramme und „Bedürfnisse“ der NutzerInnen internalisiert und Entscheidungen vorweg- bzw. übernommen. Datenanalysen, Profilerstellungen etc. zielen u. a. darauf ab, unsere zukünftigen Entscheidungen nicht nur zu erraten, sondern zu informieren.

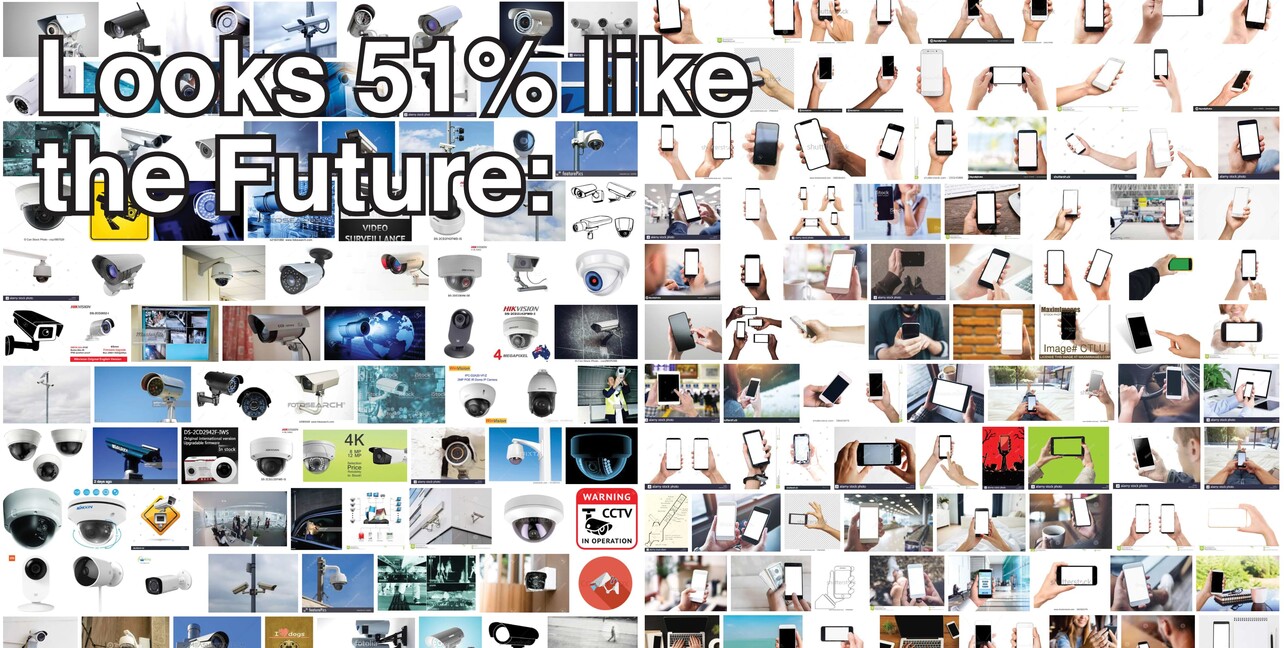

Vorerst aber treten effiziente Maschinen (Automatisierung) in Konkurrenz zu den Menschen, nicht nur was die Arbeit selbst, sondern auch was das Treffen von Entscheidungen betrifft. Was sind die Folgen wenn Entscheidungsmacht auf neuronale Netze übertragen wird? Laufen wir Gefahr, dass Handlungs- und Denkräume durch Überwachung, Big Data Rankings, Social Credit Systems etc. zunehmend kontrolliert und programmiert werden und wir uns auf dem Weg in Richtung digital strukturiertem Totalitarismus befinden? Ohne dass wir es merken, verschwinden Entscheidungs- und Verantwortungsräume in den sich auflösenden Handlungskontinuitäten von Realem und Virtuellem (Hyperreality).

Die Ausstellung untersucht Dispositionen der Entscheidung sowie Formen des Involviertseins und Mittäterschaft in autoritären politischen und algorithmischen Systemen. Welche Entscheidungen werden von uns verlangt, wie werden Entscheidungen automatisiert, in welcher Form tragen wir selbst dazu bei, bewusst oder unbewusst, wie über uns von Seiten ökonomischer, algorithmischer und staatlicher Systeme entschieden wird bzw. in wie weit agieren wir selbst autoritär? Wenn Algorithmen mehr über uns wissen als wir selbst, können sie dann unseren jeweiligen Bedürfnissen angemessener weil rationaler entscheiden, und was bedeutet das für die Vorstellung des autonomen Selbst?

Könnte nun gerade die daraus folgende Marginalisierung des Subjekts (oder die Loslösung der Subjektivität von Subjekt, Person und Mensch) eine Möglichkeit bieten, Veränderungen herbeizuführen, autoritäre Tendenzen zu verhindern oder wäre zu befürchten, dass sich hegemoniale Systeme dadurch nur verlagern, automatisiert werden, aber nicht verschwinden? In der Kunst zeichnen sich durch die Infragestellung des KünstlerInnen-, KuratorInnen- und BetrachterInnen-Subjekts neue Dispositionen ab. Ob dadurch autoritäre Strukturen im Kunstsystem aufgehoben oder nur verlagert werden, bleibt spekulativ. Welche neuen Formen gemeinsamer Entscheidungsprozesse brauchen wir?

So werden die AusstellungsbesucherInnen in Rod Dickinsons installativer Arbeit „Zero Sum“ eingeladen in einer klassischen spieltheorethischen Dilemma-Situation („Volunteer's Dilemma“ oder „The Free Rider Problem“) unterschiedliche Rollen einzunehmen und vier Möglichkeiten einer Dilemma-Situation nachzuspielen, durch die sie von einem virtuellen Moderator geführt werden. Rod Dickinson zeigt, wie durch Eingliederung in automatisierte Arbeitssysteme individueller Handlungsspielraum eingeschränkt und kontrolliert wird, legitimiert durch Optimierung (optimierte Entscheidungen), maskiert als Freiheitszugewinn.

In „Nursing Modern Fall“ untersucht İnci Eviner Widersprüche der Moderne zwischen Rationalisierung und Fortschritt, Zerstörung und Vernichtung. Sie inszeniert Überreste des rationalen Verständnisses von Universalität als (architektur)-historischen Raum, den sie als Bühne und Aktionsraum für davon Ausgeschlossene, für Menschen ohne Rechte umfunktionalisiert. Inwieweit wirkt sich dieser autoritäre/totalitäre Charakter der Moderne, gerade was Ausschlussmechanismen betrifft, auf unser heutiges Leben aus bzw. inwieweit stellt der Neoliberalismus eine irrationale Spielart instrumenteller Vernunft dar? İnci Eviner lässt auf ihrer Aktionsbühne junge Frauen immer wieder die gleichen Handlungen und Gesten ausführen, die die Ambivalenz der Moderne zwischen Fortschritt und Zerstörung widerspiegeln und wie das Unbewusste dieses Vernunftverständnisses funktionieren.

HARD-CORE experimentiert mit kuratorischen Methoden, beschäftigt sich mit Robotic Curating, entwickelte die Software Asahi 4.0, mit der Ausstellungen automatisiert kuratiert werden können. Asahi 4.0 wählt Kunstwerke über einen Zufallsgenerator aus, entsubjektiviert und kollektiviert Entscheidungsprozesse. Im Video „The Universal Blob (2)“ reflektieren fünf personifizierte Entitäten über ein kollektives Selbst und über kuratorische Praxen, die losgelöst von ästhetischen Erfahrungen und Entscheidungen – über Asahi 4.0 beispielsweise – enthierarchisiert werden können. Oder ist auch Asahi 4.0 in seinen Zufallsentscheidungen dominant, nicht wirklich kollaborativ?

Bernd Hopfengärtner und Ludwig Zeller inszenieren in ihrem Video „Life Is Good For Now“ eine spekulative Sicht auf die Schweiz, die sich entschlossen hat, das Recht auf informationelle Selbstbestimmung vollständig umzusetzen. Mont Data, eine Genossenschaft koordiniert den Berg wissenschaftlicher und kommerzieller Daten, wodurch die BürgerInnen mit neuen Entscheidungsmöglichkeiten und -aufgaben konfrontiert werden. Die beiden Künstler zeigen fiktive Erfahrungsberichte aus den Bereichen Medizin, Kultur und Alltag, in denen über die Verfügungsgewalt der eigenen Daten Handlungsmöglichkeiten gegen digitale Kontrolle und Verwertung vorgestellt und antizipiert werden.

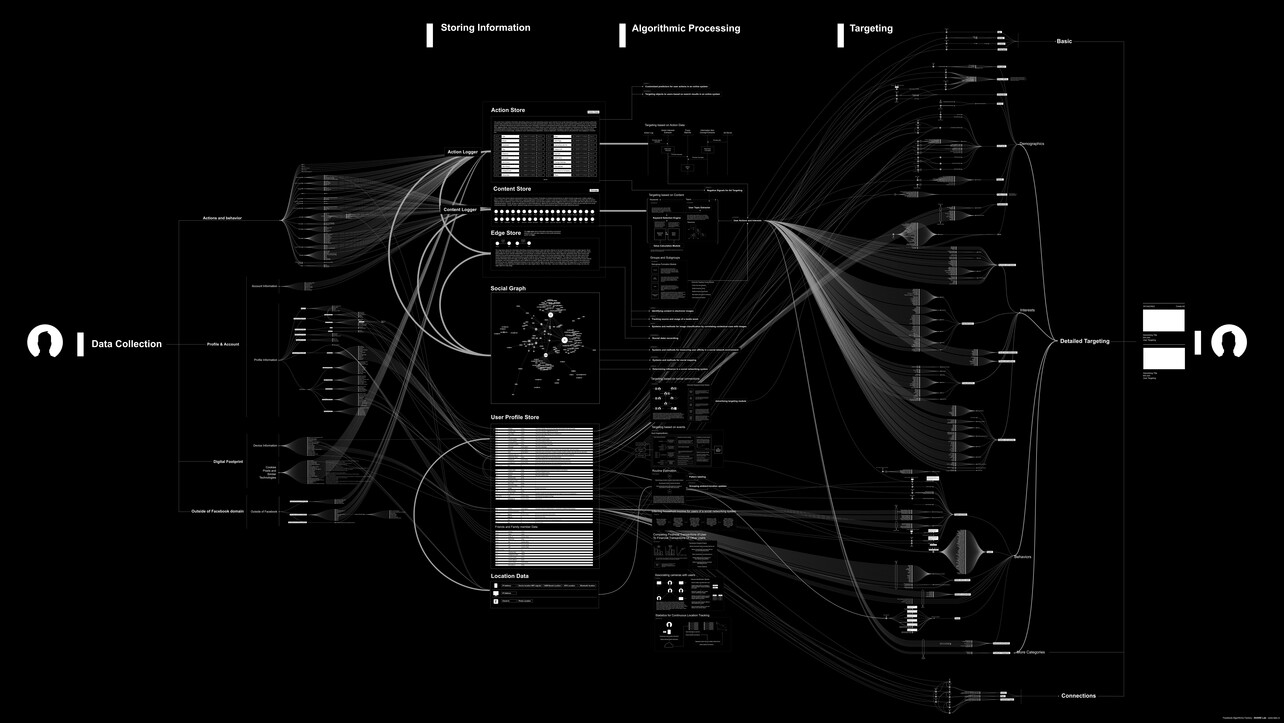

In einem Monolog schildert eine Stimme aus der Position von Facebook Vorgehensweisen des Konzerns, wie Daten ausgewertet, Verhaltensmuster und Profile erstellt werden. Das Video von Vladan Joler (SHARE Lab) beschreibt anhand von Diagrammen wie diese Mechanismen funktionieren, wie Facebook vom Verkauf der Datenauswertungen an Firmen für Produktwerbung, Mikrotargeting-Kampagnen etc. profitiert und wie dadurch zukünftige Entscheidungen von UserInnen informiert werden. Das über uns gesammelte Wissen über Vorlieben, sozialen und finanziellen Status, Gesundheit etc. kann als Druckmittel gegen uns verwendet werden. Neben dem Druck auf sozialen Medien präsent zu sein, erhöhen aber auch die UserInnen selbst den Druck dadurch permanent alles kommentieren zu müssen, was vielfach als Partizipation missverstanden wird, jedoch massiven Druck auf andere ausüben kann.

The Substance of Value behandelt eine ausgewählte Textpassage aus Das Kapital von Karl Marx und übersetzt unter Verwendung der von Isabella Kohlhuber entworfenen Schrift Bastards, den Beginn des ersten Bandes in Form, Material und Raum. „Wert besteht laut Marx im Kapitalismus in der von den Waren repräsentierten 'abstrakten Arbeit', die die Substanz der den Waren zugesprochenen Tauschwerte bildet.“ (Robert Kurz) Dadurch ergeben sich Widersprüchlichkeiten und Druckszenarien, wie jene, dass einerseits die unbeschränkte Anhäufung von Wert das Ziel ist, andererseits aber dadurch fortwährend die Wertsubstanz der Waren ausgehöhlt wird. Wie wird Bedeutung und Wert in dieser Zone von Repräsentation, Abstraktion und Realität generiert, welche Machtverhältnisse kommen dabei zum Ausdruck?

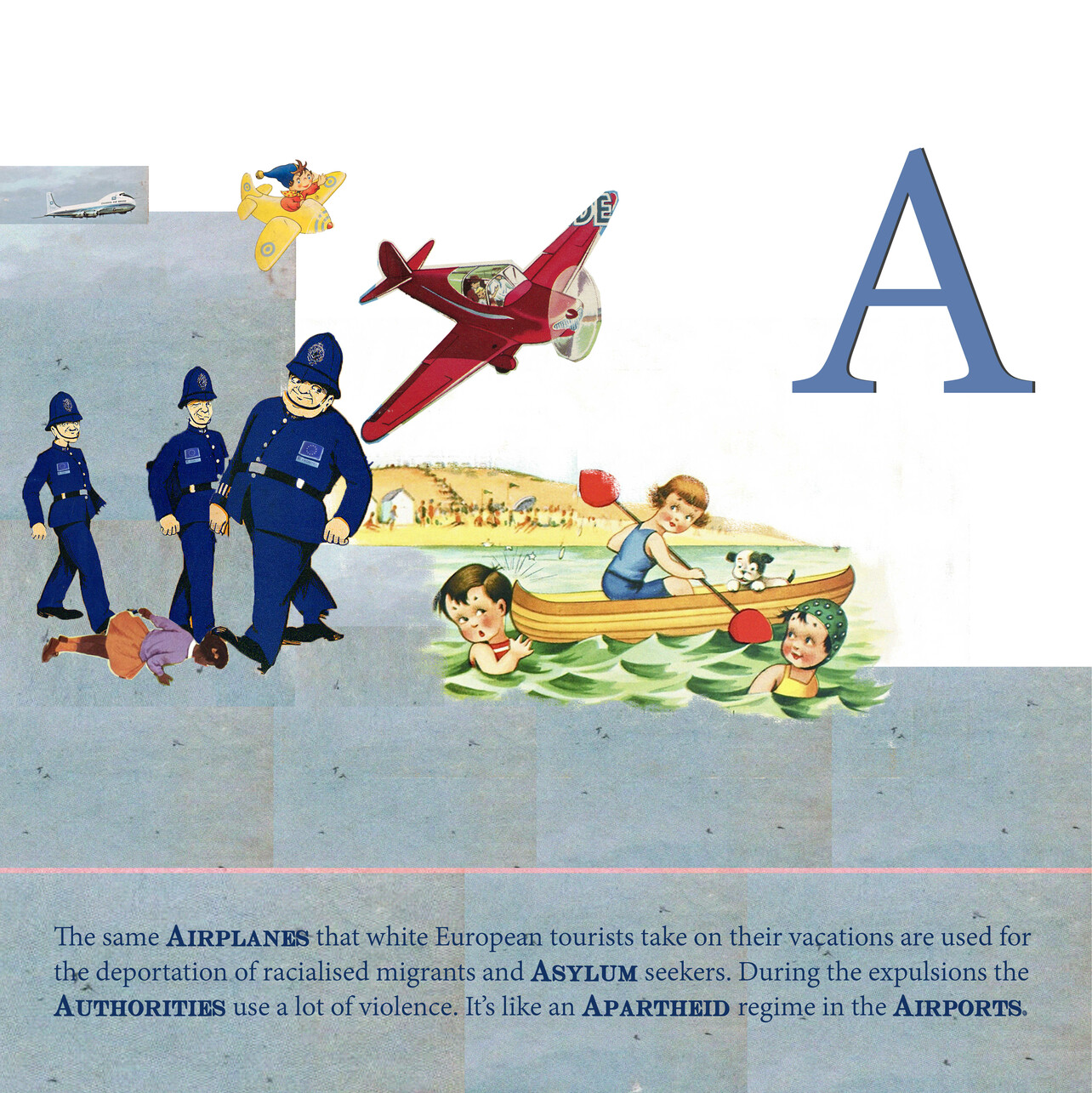

Daniela Ortiz erforscht in ihren Arbeiten Konzepte von Nationalität, Klasse, Rasse, Gleichstellungs- und Bürgerrechtspolitik, sie untersucht, wie das europäische System der Migrationskontrolle und kolonialer Rassismus auf Mustern der Ausgrenzung basieren. In ihrer als Bilderbuch konzipierten Arbeit „The ABC of Racist Europe“ stellt Daniela Ortiz eurozentrischen Narrativen, Narrative aus antikolonialer und antirassistischer Perspektive gegenüber. In der autoritären Ablehnung von Migration manifestiert sich eine Forderung nach kultureller/gesellschaftlicher Entscheidungsmacht einer weißen Mittelstandsschicht, der die politischen Entscheidungsmöglichkeiten abhanden zu gehen scheinen. Daniela Ortiz dekonstruiert hegemoniale Narrative und Praktiken und fordert Gleichstellung radikal ein.

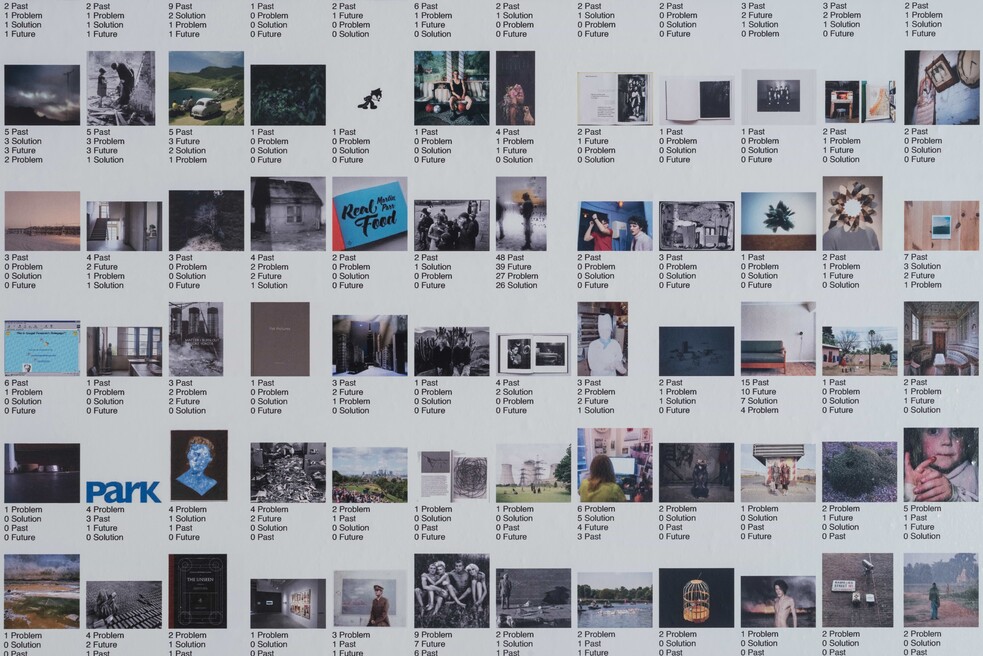

Sebastian Schmieg untersucht in seinem Projekt „Decisive.Camera“ menschliche und automatisierte Zuordnungsprozesse, beschäftigt sich mit Fragen zu Fotografie und Machine Learning. Machine Learning bedient sich Algorithmen, die auf der Grundlage eines Datensatzes lernen können, Vorhersagen zu machen, zu klassifizieren und Entscheidungen zu treffen. Die Software Decisive.Camera analysiert im Ausstellungsraum aufgenommene Fotos und entscheidet, zu welchem Anteil diese das Problem, die Lösung, die Vergangenheit oder die Zukunft abbilden. Diese Entscheidungen erfolgen automatisch und sind das Ergebnis eines Lernprozesses, den Schmieg in einem Vorgängerprojekt an die Besucher/innen der Photographers’ Gallery in London ausgelagert hatte: Diese konnten die Fotos im Archiv der Galerie, darunter Aufnahmen von Cindy Sherman, Valie Export und Trevor Paglen, den oben genannten Kategorien zuordnen und trainierten damit das Machine-Learning-System, welches nun bei Decisive.Camera zum Einsatz kommt. Wie beeinflussen wir KI-Systeme, die ihrerseits unsere Wahrnehmung verändern? Welche Entscheidungen werden KI-Systeme übernehmen und wer wird sie kontrollieren?

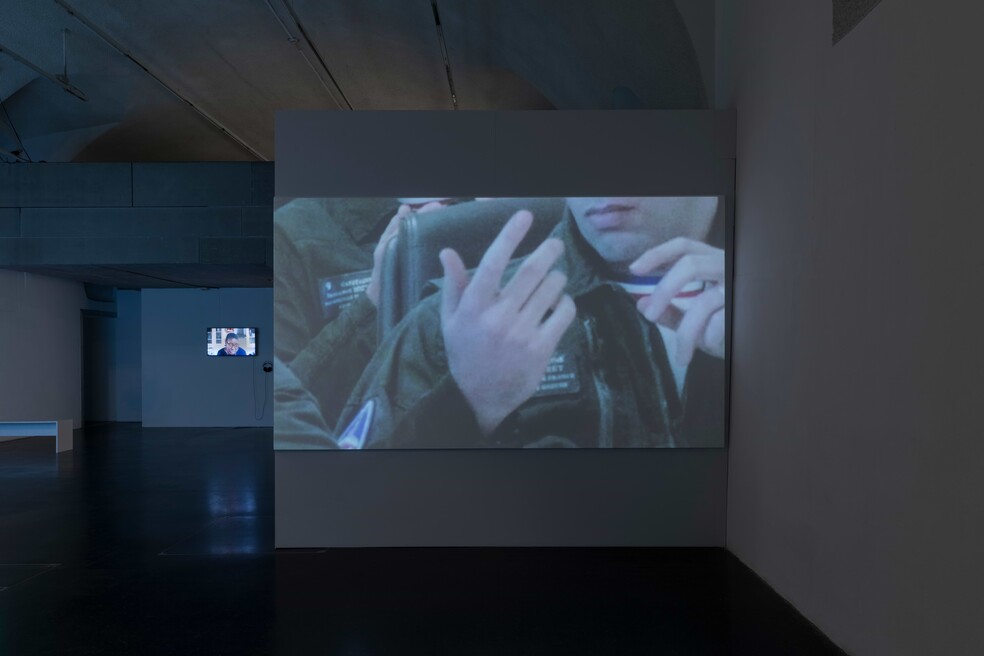

Um die Entwicklung ihrer hauptberuflichen Selbständigkeit als Künstlerin zu beschleunigen und ihren Leistungsbezug zu beenden, wurde Stefanie Schroeder zur Teilnahme an einer Maßnahme zur Unternehmensoptimierung angehalten. Eine in diesem Rahmen ermittelte Entwicklungsprognose bestimmt über den Erhalt oder die (erzwungene) Aufgabe ihrer Selbständigkeit. Stefanie Schroeder analysiert in ihrer 2-Kanal-Videoinstallation Strukturen und Funktionen des Optimierungsimperativs, untersucht, wie Optimierung und Effizienz als Wertmaßstab eingesetzt werden und als Kriterium für Entscheidungsfindung generalisiert werden. Die autoritär gestellte Forderung nach Optimierung und Effizienz wird zum vorrangigen Entscheidungskriterium. Ausschluss und Stigmatisierung werden über die zur Norm erhobene Profitevaluierung festgeschrieben und zum Dogma erhoben zur autoritären Struktur.

In ihrem Film Our Friends Electric erforscht Superflux alternative Formen und Interaktionen mit sprachbasierten KI-Assistenten. Superflux entwarf drei fiktive KI-Apparate, um potenzielle Beziehungen zu Sprachassistenten zu imaginieren: Diese fiktiven KI-Assistenten mit Namen Eddi, Karma und Sig sind keine realen Produkte, sondern stellen Archetypen potenzieller Eigenschaften solcher Geräte dar. Superflux untersucht u. a. wie menschliche Befehlsstrukturen den Umgang mit Technologie bestimmen und welche anderen Interaktionsformen möglich wären. Andererseits werden Kontrollfunktionen von KI-Systemen im Hinblick auf die nicht vorhersehbare Entwicklung selbstlernender Maschinen thematisiert.

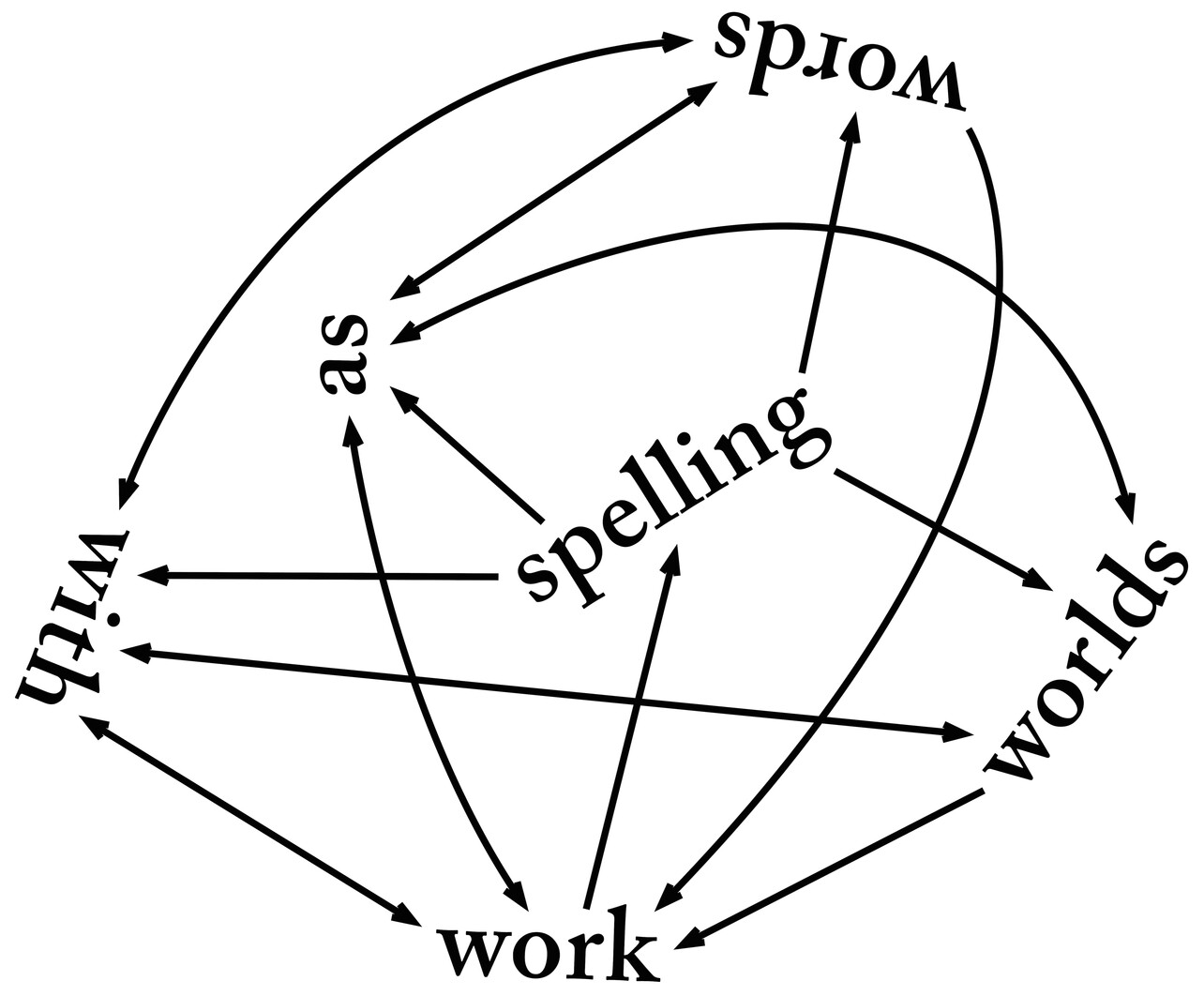

Nick Thurston gestaltet in Zusammenarbeit mit dem Schriftsteller Steven Zultanski die textbasierte Rauminstallation Authorithy, die sich mit dem Verhältnis von Macht, Autorität und AutorIn in der Literatur beschäftigt. Vier Textblöcke von Steven Zultanski beschreiben wie literarische Sprache Vorstellungen und Bilder mächtiger Charaktere erschaffen und demontieren kann. Das Diagramm auf dem Boden zeigt sechs Wörter, die aus einem dreizeiligen Gedicht von Nick Thurston stammen: „Spelling worlds / With words / As work“. In der Bildform des Diagramms wird die monolineare Struktur der Sprache gegen eine kartografische Darstellungsform ausgetauscht und auf mögliche Wort- und Bedeutungskombinationen der Wörter visuell verwiesen. Das Diagramm referiert auf Textpassagen an der Wand, in denen behauptet wird, dass Literatur mit geringen Mitteln in unserer Vorstellung komplexe Welten imaginieren, Bedeutungsräume schaffen, Macht-(phantasien) demontieren kann.

Pinar Yoldas imaginiert in ihrer Arbeit „Kitty AI: Artificial Intelligence for Governance“ eine Künstliche Intelligenz (KI), die die Weltherrschaft übernommen hat. Im Video spricht eine 3D-animierte Katze über sich selbst und ihre Aufgaben als Regierende einer im Jahr 2039 angesiedelten Megalopolis. Kitty AI tritt als gefühlsbetonte Repräsentantin eines allumfassenden KI-Regimes auf, in dem „Katzenliebe“ und Technologie PolitikerInnen ersetzen sollen. Wenn Algorithmen vieles besser als Menschen können, sind damit sowohl Hoffnungen wie Ängste verbunden. Treffen KI-Systeme die besseren Entscheidungen, weil sie mehr Daten erfassen und auswerten können? Die Verheißungen technischer Lösungskompetenzen von KI sind groß, verschwiegen werden gerne die damit verbundenen Kontrollfunktionen sowie Verlust von Entscheidungsfreiheiten. „Kitty AI“ präsentiert sich als Agentin für optimiertes Regieren in Form emotionaler Fürsorge.

Journalbeiträge

40h, max. 2 Monate. Ein Gespräch mit Stefanie Schroeder

Mit Julia Stattin sprach die Künstlerin Stefanie Schroeder über ihren Beitrag zur Gruppenausstellung "Under Pressure - Über Formen des Autoritären und die Macht der Entscheidung".